ه‰چوœںه·¥ن½œ

- ه®‰è£…JDK

- ه®‰è£…Hadoop

- ه®‰è£…MySQL

ه®‰è£…Hive

ن¸‹è½½Hiveه®‰è£…هŒ…

هڈ¯ن»¥ن»ژ Apache ه…¶ن¸ن¸€ن¸ھé•œهƒڈ站点ن¸ن¸‹è½½وœ€و–°ç¨³ه®ڑ版çڑ„ Hive, apache-hive-2.1.0-bin.tar.gzم€‚

解هژ‹ه®‰è£…Hive

ن½؟用ن»¥ن¸‹ه‘½ن»¤ه®‰è£… Hive:

sudo mv apache-hive-2.1.0-bin.tar.gz /opt

cd /opt

sudo tar -xzvf apache-hive-2.1.0-bin.tar.gz ##解هژ‹

sudo ln -s apache-hive-2.1.0-bin hive ##هˆ›ه»؛软链وژ¥

设置 Hiveçژ¯ه¢ƒهڈکé‡ڈ

编辑 .bash_profile و–‡ن»¶, هœ¨ه…¶ن¸و·»هٹ ن»¥ن¸‹ه†…ه®¹:

# Hive Env

export HIVE_HOME=/opt/hive

export PATH=$PATH:$HIVE_HOME/bin

ن½؟çژ¯ه¢ƒهڈکé‡ڈç”ںو•ˆ:

source .bash_profile

é…چç½®Hive

é…چç½®و–‡ن»¶é‡چه‘½هگچ

هœ¨è؟گè،Œ Hive ن¹‹ه‰چ需è¦پن½؟用ن»¥ن¸‹ه‘½ن»¤ن؟®و”¹é…چç½®و–‡ن»¶:

cd /opt/hive/conf

cp hive-env.sh.template hive-env.sh

cp hive-default.xml.template hive-site.xml

cp hive-log4j2.properties.template hive-log4j2.properties

cp hive-exec-log4j2.properties.template hive-exec-log4j2.properties

ن؟®و”¹hive-env.sh

ه› ن¸؛ Hive ن½؟用ن؛† Hadoop, 需è¦پهœ¨ hive-env.sh و–‡ن»¶ن¸وŒ‡ه®ڑ Hadoop ه®‰è£…è·¯ه¾„ï¼ڑ

export JAVA_HOME=/opt/java ##Javaè·¯ه¾„

export HADOOP_HOME=/opt/hadoop ##Hadoopه®‰è£…è·¯ه¾„

export HIVE_HOME=/opt/hive ##Hiveه®‰è£…è·¯ه¾„

export HIVE_CONF_DIR=/opt/hive/conf ##Hiveé…چç½®و–‡ن»¶è·¯ه¾„

ن؟®و”¹hive-site.xml

و›؟وچ¢hive-site.xmlو–‡ن»¶ن¸çڑ„ ${system:java.io.tmpdir} ه’Œ ${system:user.name}

<property><name>hive.exec.scratchdir</name><value>/tmp/hive-${user.name}</value><description>HDFS root scratch dir for Hive jobs which gets created with write all (733) permission. For each connecting user, an HDFS scratch dir: ${hive.exec.scratchdir}/<username> is created, with ${hive.scratch.dir.permission}.</description></property><property><name>hive.exec.local.scratchdir</name><value>/tmp/${user.name}</value><description>Local scratch space for Hive jobs</description></property><property><name>hive.downloaded.resources.dir</name><value>/tmp/hive/resources</value><description>Temporary local directory for added resources in the remote file system.</description></property><property><name>hive.querylog.location</name><value>/tmp/${user.name}</value><description>Location of Hive run time structured log file</description></property><property><name>hive.server2.logging.operation.log.location</name><value>/tmp/${user.name}/operation_logs</value><description>Top level directory where operation logs are stored if logging functionality is enabled</description></property>é…چç½®Hive Metastore

é»ک认وƒ…ه†µن¸‹, Hiveçڑ„ه…ƒو•°وچ®ن؟هکهœ¨ن؛†ه†…هµŒçڑ„ derby و•°وچ®ه؛“里, ن½†ن¸€èˆ¬وƒ…ه†µن¸‹ç”ںن؛§çژ¯ه¢ƒن½؟用 MySQL و¥هکو”¾ Hive ه…ƒو•°وچ®م€‚

- ه°† mysql-connector-java-5.1.39.jar و”¾ه…¥ $HIVE_HOME/lib ن¸‹م€‚

- hive-site.xml ن¸é…چç½® MySQL و•°وچ®ه؛“è؟وژ¥ن؟،وپ¯

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&characterEncoding=UTF-8&useSSL=false</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>hive</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>hive</value> </property>

ن¸؛Hiveهˆ›ه»؛HDFSç›®ه½•

هœ¨ Hive ن¸هˆ›ه»؛è،¨ن¹‹ه‰چ需è¦پن½؟用ن»¥ن¸‹ HDFS ه‘½ن»¤هˆ›ه»؛ /tmp ه’Œ /user/hive/warehouse (hive-site.xml é…چç½®و–‡ن»¶ن¸ه±و€§é،¹ hive.metastore.warehouse.dir çڑ„é»ک认ه€¼) ç›®ه½•ه¹¶ç»™ه®ƒن»¬èµ‹ه†™وƒé™گم€‚

hdfs dfs -mkdir /tmp

hdfs dfs -mkdir /usr/hive/warehouse

hdfs dfs -chmod g+w /tmp

hdfs dfs -chmod g+w /usr/hive/warehouse

è؟گè،ŒHive

هœ¨ه‘½ن»¤è،Œè؟گè،Œ hive ه‘½ن»¤و—¶ه؟…é،»ن؟è¯پ HDFS ه·²ç»ڈهگ¯هٹ¨م€‚هڈ¯ن»¥ن½؟用 start-dfs.sh و¥هگ¯هٹ¨ HDFSم€‚

ن»ژ Hive 2.1 版وœ¬ه¼€ه§‹, وˆ‘ن»¬éœ€è¦په…ˆè؟گè،Œ schematool ه‘½ن»¤و¥و‰§è،Œهˆه§‹هŒ–و“چن½œم€‚

schematool -dbType mysql -initSchema

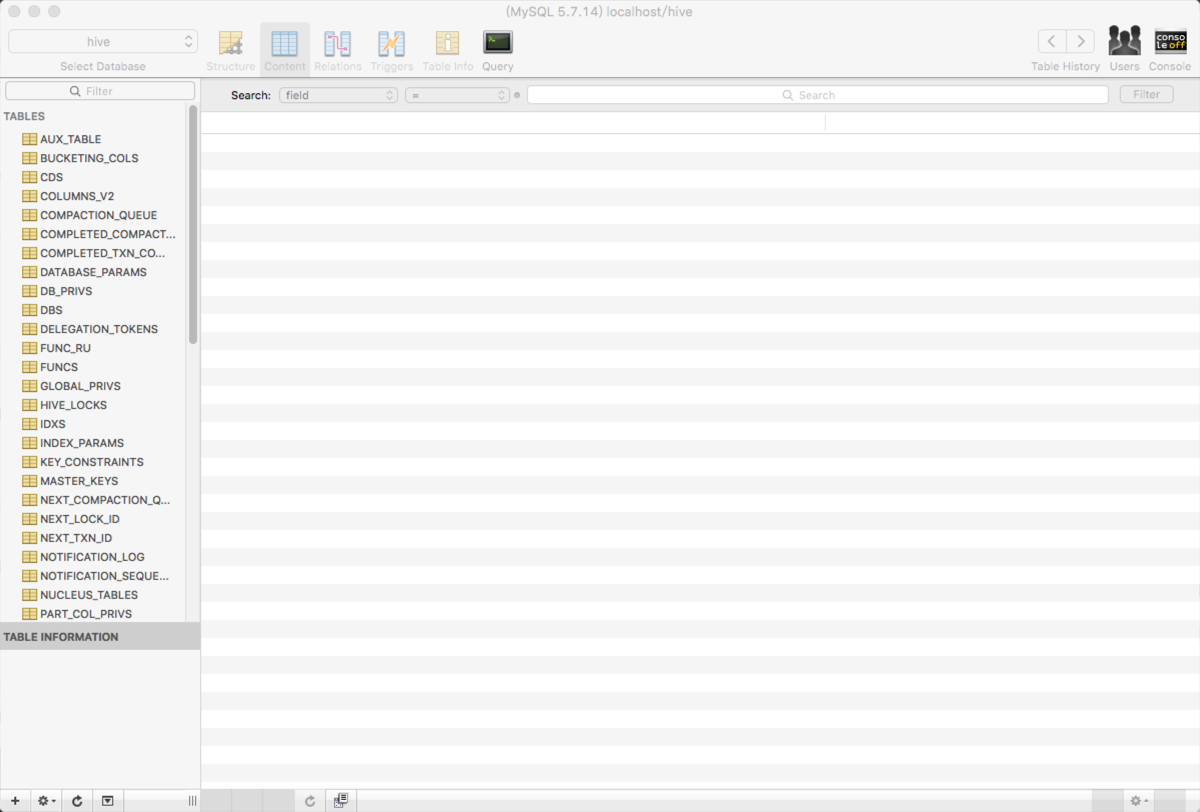

و‰§è،Œوˆگهٹںهگژ,هڈ¯ن»¥ن½؟用 Sequel Pro وں¥çœ‹ه…ƒو•°وچ®ه؛“ hive وک¯هگ¦ه·²ç»ڈهˆ›ه»؛وˆگهٹںم€‚

è¦پن½؟用 Hive CLI(Hive command line interface), هڈ¯ن»¥هœ¨ç»ˆç«¯è¾“ه…¥ن»¥ن¸‹ه‘½ن»¤ï¼ڑ

hive

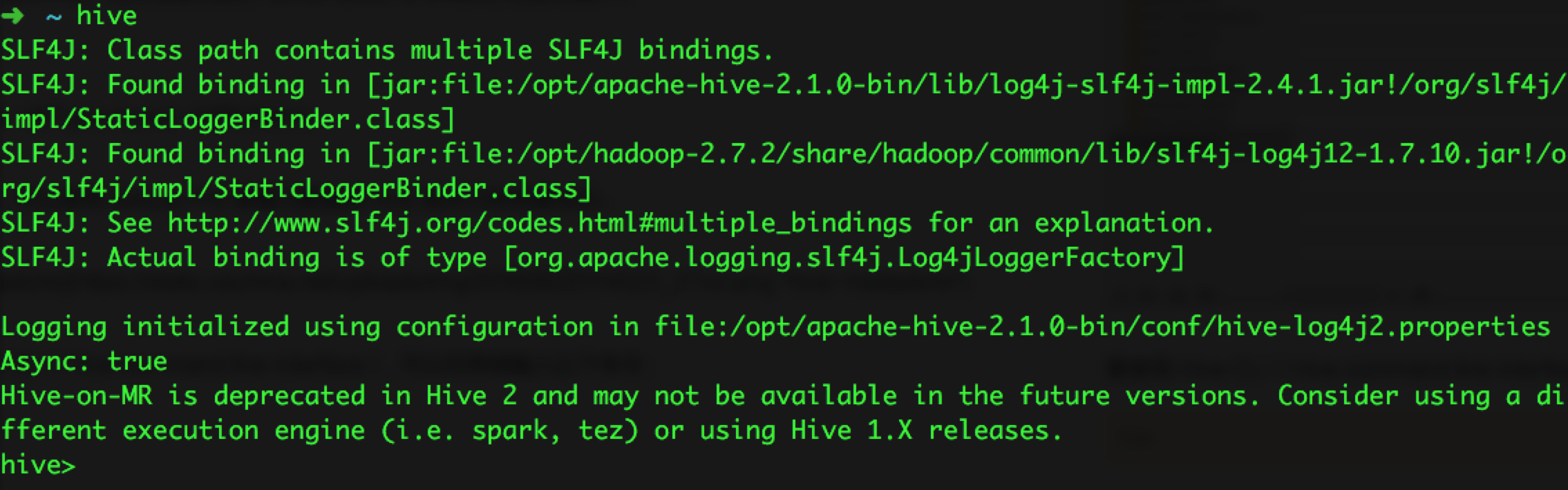

هگ¯هٹ¨ن؟،وپ¯ه¦‚ن¸‹:

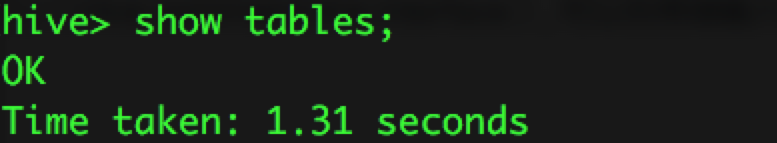

ن½؟用 show tables و¥وک¾ç¤؛و‰€وœ‰çڑ„è،¨:

é—®é¢کو€»ç»“

SSLé—®é¢ک

هگ¯هٹ¨ hive و—¶ï¼Œوڈگç¤؛ن»¥ن¸‹ن؟،وپ¯ï¼ڑ

Sat May 21 10:25:12 CST 2016 WARN: Establishing SSL connection without server's identity verification is not recommended. According to MySQL 5.5.45+, 5.6.26+ and 5.7.6+ requirements SSL

connection must be established by default if explicit option isn't set. For compliance with existing applications not using SSL the verifyServerCertificate property is set to 'false'. You need either to explicitly disable SSL by setting useSSL=false, or set useSSL=true and provide truststore for server certificate verification.

解ه†³و–¹و³•ï¼ڑهœ¨ hive-site.xml é…چç½®و–‡ن»¶ن¸ javax.jdo.option.ConnectionURL é…چç½®é،¹çڑ„ه€¼ن¸ٹهٹ ن¸ٹ useSSL=falseم€‚هچ³وœ€هگژçڑ„é…چç½®ه¦‚ن¸‹ï¼ڑ

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&useUnicode=true&characterEncoding=UTF-8&useSSL=false</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

initSchemaé—®é¢ک

هگ¯هٹ¨ hive و—¶ï¼Œوڈگç¤؛ن»¥ن¸‹ن؟،وپ¯ï¼ڑ

Exception in thread "main" java.lang.RuntimeException: Hive metastore database is not initialized. Please use schematool (e.g. ./schematool -initSchema -dbType ...) to create the schema. If needed, don't forget to include the option to auto-create the underlying database in your JDBC connection string (e.g. ?createDatabaseIfNotExist=true for mysql)

解ه†³و–¹و³•ï¼ڑو‰§è،Œ schematool -initSchema -dbType mysqlم€‚هچ³ه®‰è£… Hive هگژ,هœ¨é¦–و¬،è؟گè،Œ hive ن¹‹ه‰چè¦پو‰§è،Œن»¥ن¸ٹه‘½ن»¤م€‚

相ه¯¹è·¯ه¾„é—®é¢ک

هگ¯هٹ¨Hiveو—¶وٹ¥ن»¥ن¸‹é”™è¯¯:

Exception in thread "main"java.lang.RuntimeException: java.lang.IllegalArgumentException:java.net.URISyntaxException: Relative path in absolute URI:${system:java.io.tmpdir%7D/$%7Bsystem:user.name%7D

atorg.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:444)

atorg.apache.hadoop.hive.cli.CliDriver.run(CliDriver.java:672)

atorg.apache.hadoop.hive.cli.CliDriver.main(CliDriver.java:616)

atsun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

atsun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:57)

atsun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

atjava.lang.reflect.Method.invoke(Method.java:606)

atorg.apache.hadoop.util.RunJar.main(RunJar.java:160)

Caused by: java.lang.IllegalArgumentException:java.net.URISyntaxException: Relative path in absolute URI:${system:java.io.tmpdir%7D/$%7Bsystem:user.name%7D

atorg.apache.hadoop.fs.Path.initialize(Path.java:148)

atorg.apache.hadoop.fs.Path.<init>(Path.java:126)

atorg.apache.hadoop.hive.ql.session.SessionState.createSessionDirs(SessionState.java:487)

atorg.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:430)

... 7more

解ه†³و–¹و،ˆï¼ڑه°† hive-site.xml ن¸çڑ„ ${system:java.io.tmpdir} ه’Œ ${system:user.name} هˆ†هˆ«و›؟وچ¢وˆگ /tmp ه’Œ ${user.name}

mysql-connector-java版وœ¬é—®é¢ک

هگ¯هٹ¨Hiveو—¶وٹ¥ن»¥ن¸‹é”™è¯¯ï¼ڑ

Exception in thread "main" java.lang.RuntimeException: org.apache.hadoop.hive.ql.metadata.HiveException: java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

at org.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:578)

at org.apache.hadoop.hive.ql.session.SessionState.beginStart(SessionState.java:518)

at org.apache.hadoop.hive.cli.CliDriver.run(CliDriver.java:705)

at org.apache.hadoop.hive.cli.CliDriver.main(CliDriver.java:641)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:498)

at org.apache.hadoop.util.RunJar.run(RunJar.java:221)

at org.apache.hadoop.util.RunJar.main(RunJar.java:136)

Caused by: org.apache.hadoop.hive.ql.metadata.HiveException: java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

at org.apache.hadoop.hive.ql.metadata.Hive.registerAllFunctionsOnce(Hive.java:226)

at org.apache.hadoop.hive.ql.metadata.Hive.<init>(Hive.java:366)

at org.apache.hadoop.hive.ql.metadata.Hive.create(Hive.java:310)

at org.apache.hadoop.hive.ql.metadata.Hive.getInternal(Hive.java:290)

at org.apache.hadoop.hive.ql.metadata.Hive.get(Hive.java:266)

at org.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:545)

... 9 more

Caused by: java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

at org.apache.hadoop.hive.metastore.MetaStoreUtils.newInstance(MetaStoreUtils.java:1627)

at org.apache.hadoop.hive.metastore.RetryingMetaStoreClient.<init>(RetryingMetaStoreClient.java:80)

at org.apache.hadoop.hive.metastore.RetryingMetaStoreClient.getProxy(RetryingMetaStoreClient.java:130)

at org.apache.hadoop.hive.metastore.RetryingMetaStoreClient.getProxy(RetryingMetaStoreClient.java:101)

at org.apache.hadoop.hive.ql.metadata.Hive.createMetaStoreClient(Hive.java:3317)

at org.apache.hadoop.hive.ql.metadata.Hive.getMSC(Hive.java:3356)

at org.apache.hadoop.hive.ql.metadata.Hive.getMSC(Hive.java:3336)

at org.apache.hadoop.hive.ql.metadata.Hive.getAllFunctions(Hive.java:3590)

at org.apache.hadoop.hive.ql.metadata.Hive.reloadFunctions(Hive.java:236)

at org.apache.hadoop.hive.ql.metadata.Hive.registerAllFunctionsOnce(Hive.java:221)

... 14 more

Caused by: java.lang.reflect.InvocationTargetException

at sun.reflect.NativeConstructorAccessorImpl.newInstance0(Native Method)

at sun.reflect.NativeConstructorAccessorImpl.newInstance(NativeConstructorAccessorImpl.java:62)

at sun.reflect.DelegatingConstructorAccessorImpl.newInstance(DelegatingConstructorAccessorImpl.java:45)

at java.lang.reflect.Constructor.newInstance(Constructor.java:423)

at org.apache.hadoop.hive.metastore.MetaStoreUtils.newInstance(MetaStoreUtils.java:1625)

... 23 more

Caused by: javax.jdo.JDODataStoreException: Exception thrown obtaining schema column information from datastore

NestedThrowables:

java.sql.SQLException: Column name pattern can not be NULL or empty.

at org.datanucleus.api.jdo.NucleusJDOHelper.getJDOExceptionForNucleusException(NucleusJDOHelper.java:543)

at org.datanucleus.api.jdo.JDOPersistenceManager.jdoMakePersistent(JDOPersistenceManager.java:720)

at org.datanucleus.api.jdo.JDOPersistenceManager.makePersistent(JDOPersistenceManager.java:740)

at org.apache.hadoop.hive.metastore.ObjectStore.setMetaStoreSchemaVersion(ObjectStore.java:7763)

at org.apache.hadoop.hive.metastore.ObjectStore.checkSchema(ObjectStore.java:7657)

at org.apache.hadoop.hive.metastore.ObjectStore.verifySchema(ObjectStore.java:7632)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:498)

at org.apache.hadoop.hive.metastore.RawStoreProxy.invoke(RawStoreProxy.java:101)

at com.sun.proxy.$Proxy21.verifySchema(Unknown Source)

at org.apache.hadoop.hive.metastore.HiveMetaStore$HMSHandler.getMS(HiveMetaStore.java:547)

at org.apache.hadoop.hive.metastore.HiveMetaStore$HMSHandler.createDefaultDB(HiveMetaStore.java:612)

at org.apache.hadoop.hive.metastore.HiveMetaStore$HMSHandler.init(HiveMetaStore.java:398)

at org.apache.hadoop.hive.metastore.RetryingHMSHandler.<init>(RetryingHMSHandler.java:78)

at org.apache.hadoop.hive.metastore.RetryingHMSHandler.getProxy(RetryingHMSHandler.java:84)

at org.apache.hadoop.hive.metastore.HiveMetaStore.newRetryingHMSHandler(HiveMetaStore.java:6396)

at org.apache.hadoop.hive.metastore.HiveMetaStoreClient.<init>(HiveMetaStoreClient.java:236)

at org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient.<init>(SessionHiveMetaStoreClient.java:70)

... 28 more

解ه†³و–¹و،ˆï¼ڑه°† $HIVE_HOME/lib ن¸‹ çڑ„ mysql-connector-java-6.0.3.jar و›؟وچ¢وˆگ mysql-connector-java-5.1.39.jarم€‚ هژںه› هˆ†وگï¼ڑmysql-connector-java 6.x 版وœ¬ ه’Œ 5.1.x 版وœ¬ن¸چه…¼ه®¹ , nullNamePatternMatchesAll è؟وژ¥ه±و€§çڑ„é»ک认ه€¼هœ¨ mysql-connector-java 5.1 ه’Œ 6.0 ن¹‹é—´هڈ‘ç”ںن؛†و”¹هڈک. هœ¨ 5.1 版وœ¬ن¸é»ک认ه€¼وک¯ true, 而 6.0 版وœ¬ن¸é»ک认ه€¼وک¯ falseم€‚هڈ¯ن»¥هڈ‚考و–‡ç« آ https://liquibase.jira.com/browse/CORE-2723م€‚

相ه…³وژ¨èچگ

mysqlه®‰è£…هŒ…,mysqlه¤–ç•Œو•°وچ®ه؛“ن½œن¸؛هکه‚¨hiveه…ƒو•°وچ®çڑ„هکه‚¨ن»‹è´¨ï¼Œه®ƒçڑ„هکهœ¨ï¼Œو–¹ن¾؟hive用وˆ·و ¹وچ®è‡ھè؛«çڑ„需و±‚ه¯¹و•°وچ®è؟›è،Œهˆ†وگه¤„çگ†م€‚

1.وˆ‘ن»¬é‡‡ç”¨MySQLو•°وچ®ه؛“ن؟هکHiveçڑ„ه…ƒو•°وچ®ï¼Œè€Œن¸چوک¯é‡‡ç”¨Hiveè‡ھه¸¦çڑ„derbyو¥هکه‚¨ه…ƒو•°وچ®ï¼Œه› و¤éœ€è¦پهœ¨Ubuntu里ه®‰è£…MySQL ن½؟用ن»¥ن¸‹ه‘½ن»¤هچ³هڈ¯è؟›è،Œmysqlه®‰è£…ï¼ڑ 2.MySQLه®‰è£…ه®Œوˆگن¹‹هگژ,هڈ¯ç”¨ن»¥ن¸‹ه‘½ن»¤هگ¯هٹ¨ه’Œه…³é—mysqlوœچهٹ،ه™¨

讲解ن؛†ه¦‚ن½•ه®‰è£…هں؛ن؛ژhiveçڑ„ه…ƒو•°وچ®هœ¨è؟œç«¯هکه‚¨هˆ°Mysqlçڑ„و–¹و،ˆï¼Œو¥éھ¤è¯¦ç»†é€‚هگˆèڈœé¸ںه®‰è£…ن½؟用

1.وˆ‘ن»¬é‡‡ç”¨MySQLو•°وچ®ه؛“ن؟هکHiveçڑ„ه…ƒو•°وچ®ï¼Œè€Œن¸چوک¯é‡‡ç”¨Hiveè‡ھه¸¦çڑ„derbyو¥هکه‚¨ه…ƒو•°وچ®ï¼Œه› و¤éœ€è¦پهœ¨Ubuntu里ه®‰è£…MySQL ن½؟用ن»¥ن¸‹ه‘½ن»¤هچ³هڈ¯è؟›è،Œmysqlه®‰è£…ï¼ڑ 2.MySQLه®‰è£…ه®Œوˆگن¹‹هگژ,هڈ¯ç”¨ن»¥ن¸‹ه‘½ن»¤هگ¯هٹ¨ه’Œه…³é—mysqlوœچهٹ،ه™¨

و”¯وŒپmysql8.x,ن½؟用utf8mb4ç¼–ç پم€‚

ه…ƒو•°وچ®هکه‚¨ Hive ه°†ه…ƒو•°وچ®هکه‚¨هœ¨و•°وچ®ه؛“ن¸ï¼Œه¦‚ mysqlم€پderbyم€‚Hive ن¸çڑ„ه…ƒو•°وچ®هŒ…و‹¬è،¨çڑ„هگچه—,è،¨çڑ„هˆ—ه’Œهˆ†هŒ؛هڈٹه…¶ه±و€§ï¼Œè،¨çڑ„ه±و€§ï¼ˆوک¯هگ¦ن¸؛ه¤–部è،¨ç‰ï¼‰ï¼Œè،¨çڑ„و•°وچ®و‰€هœ¨ç›®ه½•ç‰م€‚ 解é‡ٹه™¨م€پ编译ه™¨م€پن¼کهŒ–ه™¨م€پو‰§è،Œه™¨ 解é‡ٹه™¨م€پ...

⼤و•°وچ®ه¹³هڈ°ن¸‹هگ„ç§چو“چن½œçڑ„ه…ƒو•°وچ®è®°ه½• و•°وچ®و‰“و ‡ç¾(ه¯¹ن؛ژç»´ه؛¦ وŒ‡و ‡ ETLç‰) هڈ¯وں¥è¯¢hive storm spark sqoop oozie nifi ه…ƒو•°وچ®ï¼Œهڈ¯â¾ƒه®ڑن¹‰ه®çژ°â¾ƒâ¼°çڑ„需è¦پوں¥çœ‹ه’Œç»´وٹ¤çڑ„⼯ه…· و•°وچ®وµپ转وµپ程çڑ„ه›¾هƒڈهŒ–ه±•çژ° ه…ƒو•°وچ®و“چن½œè®°ه½•ن¸ژهگ„ç§چ...

و‰€وœ‰و•°وچ®وƒé™گ Sentry Hadoop集群ه…ƒو•°وچ®ه’Œو•°وچ®هکه‚¨وڈگن¾›é›†ن¸م€پ细粒ه؛¦çڑ„è®؟é—®وژ§هˆ¶é،¹â½¬ 14 و•°وچ®هڈ¯è§†هŒ– Kibana ⽤ن؛ژه’Œ Elasticsearch ⼀起ن½؟⽤çڑ„ه¼€و؛گçڑ„هˆ†وگن¸ژهڈ¯è§†هŒ–ه¹³هڈ° 15 و•°وچ®وŒ–وژک Mahout هں؛ن؛ژhadoopçڑ„وœ؛ه™¨ه¦ن¹ ه’Œو•°وچ®...

3 ن¼ ç»ںو•°وچ®ن»“ه؛“هœ¨â¾¯ه¯¹و›´â¼¤è§„و¨،و•°وچ®و—¶وک¾ه¾—â¼’ن¸چن»ژ⼼,هœ¨ه¯„ه¸Œوœ›ن؛ژ⼤و•°وچ®ه¹³هڈ°و—¶ï¼ŒMapReduce 编程门و§›è®©ه¾ˆه¤ڑو•°وچ®هˆ†وگه¸ˆوœ›â½½هچ´و¥ï¼Œâ½½Hive وک¯هں؛ن؛ژHadoopçڑ„â¼€ن¸ھو•°وچ®ن»“ه؛“⼯ه…·ï¼Œهڈ¯ن»¥ه°†ç»“و„هŒ–çڑ„و•°وچ®â½‚ن»¶وک ه°„ن¸؛â¼€ه¼ و•°وچ®ه؛“è،¨ï¼Œه¹¶...

OpenVMC م€ٹç؛¢è±،ن؛‘è…¾ه¼€و”¾è§†é¢‘ه¤§و•°وچ®ç®،çگ†ه¹³هڈ°V1.0ن½؟用و–‡و،£م€‹ #OpenVMC ...7م€پé…چهگˆhive mysql ه…ƒو•°وچ®هکه‚¨م€‚ 8م€پç³»ç»ںه»؛è®®200Gن»¥ن¸ٹç©؛é—²ç£پç›کç©؛é—´ #4.ه®‰è£… 软ن»¶ن¸»و¨،ه—و— 需ه®‰è£…,ه°†seasbase.jarه’Œ videoRe

该ن؛§ه“پو£هœ¨ه¼€هڈ‘é«کو€§èƒ½é›†وˆگو•°وچ®ç®،çگ†ه¹³هڈ°ï¼Œè¯¥ه¹³هڈ°ه°†و— ç¼هœ°è؟›è،Œو•°وچ®é›†وˆگ,و•°وچ®هˆ†وگ,و•°وچ®è´¨é‡ڈ,و•°وچ®ه‡†ه¤‡ï¼Œè™ڑو‹ںو•°وچ®هˆ›ه»؛,ه…ƒو•°وچ®هڈ‘çژ°ï¼Œه¼‚ه¸¸هڈ‘çژ°ï¼Œوٹ¥ه‘ٹه’Œهˆ†وگم€‚ ه®ƒè؟که…·وœ‰Hadoop(ه¤§و•°وچ®ï¼‰و”¯وŒپ,هڈ¯ه°†و–‡ن»¶ç§»ه…¥Hadoop Grid...

وٹ€وœ¯ç‚¹5م€€ن½؟用Sqoop ن»ژMySQL ه¯¼ه…¥و•°وچ® 2ï¼ژ2ï¼ژ4م€€HBase وٹ€وœ¯ç‚¹6م€€HBase ه¯¼ه…¥HDFS وٹ€وœ¯ç‚¹7م€€ه°†HBase ن½œن¸؛MapReduce çڑ„و•°وچ®و؛گ 2ï¼ژ3م€€ه°†و•°وچ®ه¯¼ه‡؛Hadoop 2ï¼ژ3ï¼ژ1م€€ه°†و•°وچ®ه¯¼ه…¥وœ¬هœ°و–‡ن»¶ç³»ç»ں وٹ€وœ¯ç‚¹8م€€è‡ھهٹ¨ه¤چهˆ¶HDFS ن¸çڑ„...

means ه’Œو–‡وœ¬ 9ï¼ژ3ï¼ژ4م€€ه…¶ن»–Mahout clustering ç®—و³• ï¼ژ9ï¼ژ4م€€وœ¬ç« ه°ڈ结第5 部هˆ†م€€é©¯وœچه¤§è±،10م€€و·±ه…¥è§£وگ Hive10ï¼ژ1م€€Hive هں؛ç،€10ï¼ژ1ï¼ژ1م€€ه®‰è£…10ï¼ژ1ï¼ژ2م€€ه…ƒهکه‚¨10ï¼ژ1ï¼ژ3م€€و•°وچ®ه؛“م€پè،¨م€پهˆ†هŒ؛ه’Œهکه‚¨10ï¼ژ1ï¼ژ4م€€و•°وچ®و¨،ه‹...

6م€پç†ںو‚‰ن¸»و•°وچ®م€په…ƒو•°وچ®م€پو•°وچ®è´¨é‡ڈم€په’Œو•°وچ®ه»؛و¨،ç‰و•°وچ®و²»çگ†ç›¸ه…³çڑ„ن½“ç³»ه’Œو–¹و³•; 7م€په…·ه¤‡è¾ƒه¼؛çڑ„逻辑و€ç»´èƒ½هٹ›م€پو•°وچ®و•ڈو„ںه؛¦ï¼Œو“…ن؛ژهˆ©ç”¨و•°وچ®هڈ‘çژ°é—®ه¤§و•°وچ®و¶و„ه¸ˆçڑ„ه²—ن½چèپŒè´£ه…¨و–‡ه…±4é،µï¼Œه½“ه‰چن¸؛第3é،µم€‚ه¤§و•°وچ®و¶و„ه¸ˆçڑ„ه²—ن½چèپŒè´£...

èœکè››ن¾ هں؛ن؛ژscrapy-redisçڑ„é€ڑ用هˆ†ه¸ƒه¼ڈ爬虫و،†و¶ç›®ه½• demo采集و•ˆوœçˆ¬è™«ه…ƒو•°وچ®é›†ç¾¤و¨،ه¼ڈ独立و¨،ه¼ڈ附ن»¶ن¸‹è½½ kafkaه®و—¶é‡‡é›†ç›‘وژ§هٹں能è‡ھهٹ¨ه»؛è،¨è‡ھهٹ¨ç”ںوˆگ爬虫ن»£ç پ,هڈھ需编ه†™ه°‘é‡ڈن»£ç پهچ³هڈ¯ه®Œوˆگهˆ†ه¸ƒه¼ڈ爬虫è‡ھهٹ¨هکه‚¨ه…ƒو•°وچ®ï¼Œهˆ†وگç»ںè®،...